Фейк 2.0: правда больше не самоочевидна

Обзор лучших сервисов для обнаружения дипфейков.

Если ещё недавно бытовала поговорка «пока не увижу — не поверю», то сегодня она трансформировалась: «даже если увижу — проверю дважды». Генеративные модели научились настолько убедительно «клонировать» лица, голоса и целые манеры поведения, что любое видео или аудио требует критической проверки. В этой статье собраны как бытовые, так и профессиональные методы, позволяющие отсечь фейк на разных уровнях сложности.

Материал адресован широкому кругу читателей: журналистам, SMM-менеджерам, разработчикам систем распознавания, учащимся — и всем, кому ежедневно приходится доверять или отвергать цифровой контент. Вы найдёте практичные чек-листы, ссылки на сервисы и краткий обзор научных работ, задающих тон в войне «генератор против детектора».

Принцип работы дипфейков: от GAN до диффузий и дальше

Термин «дипфейк» обозначает медиафайл, синтезированный нейронной сетью. Первая волна подделок строилась на состязательных сетях (GAN), в которых две модели — генератор и дискриминатор — совершенствовали друг друга. Сегодня пальму первенства перехватывают диффузионные модели: они зашумляют изображение до случайной каши, а потом шаг за шагом «вычёрпывают» шум, пока не проявится новое лицо. В аудио-сфере активно применяются автокодеки и трансформеры, способные переносить тембр и интонации.

Чем совершеннее архитектура генерации, тем тоньше артефакты, однако «почерк» модели остаётся. Он проявляется в виде статистических огрехов, которые специалист или алгоритм может вычислить при детальном анализе.

Новейшие архитектуры 2025 года используют комбинацию трансформеров и диффузионных моделей с механизмами внимания, что позволяет создавать сверхреалистичные изображения с точной синхронизацией движений губ и мимики. Модели типа VideoFlow-HD и NeRF-Audio-Visual синтезируют полностью синхронизированные мультимодальные последовательности с учетом физики света и акустики помещения.

Типичные артефакты: детали, которые выдают ложь

Даже продвинутому дипфейку трудно подделать каждую мелочь. Классический чек-лист включает:

- Моргание глаз. Алгоритм может забыть о естественной частоте (15–20 раз в минуту) или сделать моргание асинхронным.

- Зубы и язык. Сеть часто создаёт цельную «пластинку» без промежутков между зубами и неестественно гладкий язык.

- Тени и блики. Несоответствие источников света на лице и фоне, отсутствие естественного зерна кожи.

- Ушные раковины и украшения. Серьги «срастаются» с шеей, а уши теряют чёткий контур.

- Аудио-дыхание. В синтетической речи редки паузы на вдох, спектр слишком ровный, без микро-колебаний громкости.

- Граница волос. Современные модели всё ещё сложно справляются с точной детализацией перехода волос ко лбу, создавая либо слишком резкую, либо размытую границу.

- Непоследовательность освещения при повороте головы. При движении лица тени и блики должны смещаться согласованно с источниками света в помещении.

- Рассинхронизация со звуком окружения. В подлинном видео фоновые шумы (эхо, реверберация) соответствуют акустике помещения.

Заметив хотя бы два-три признака, стоит перейти к инструментальным методам проверки.

Инструментальные методы: когда глаз устал

Пиксельный и частотный анализ

Компьютерное зрение позволяет вскрыть скрытые паттерны. ELA (Error Level Analysis) сравнивает JPEG-версии разной степени сжатия: зоны, где ошибка распределена неравномерно, чаще всего подвергались монтажу. Частотный анализ строит спектр Фурье, выявляя повторяющиеся текстуры, характерные для генеративных сетей.

Для видео применяют optical-flow consistency: если лицо «скользит» относительно тела, образуются микро-сдвиги, невидимые глазу, но хорошо ловимые математикой.

Нейроморфные детекторы используют биоинспирированные алгоритмы, имитирующие работу зрительной коры человека. Они анализируют видео не покадрово, а в динамике, выявляя несогласованность в микромимике и естественном треморе головы. Технология Spiking Neural Networks позволяет работать с высокой временной точностью при низком энергопотреблении, что особенно важно для мобильных устройств.

Проверка метаданных и контекста

Нередко EXIF-данные хранят упоминания о DeepFaceLab или свежей версии After Effects, что несочетаемо с «архивной» легендой ролика. Даже когда метаданные обрезаны, помогает обратный поиск изображений и хронология публикаций: найдите кадр в Google Images, Yandex Картинках или TinEye и сопоставьте даты.

Анализ цифровой подписи устройства — каждая камера оставляет уникальный шумовой паттерн (Camera Fingerprint) в виде PRNU (Photo Response Non-Uniformity). Извлечение и сравнение этих паттернов позволяет определить, был ли контент снят на заявленное устройство.

ИИ-детекторы первого поколения

Первые коммерческие детекторы обучались на датасетах FaceForensics++ и DFDC. Они ищут статистические расхождения, которые глаз не видит: несимметричные частоты JPEG-квантования, следы «face warping», нарушение текстуры кожи при апскейле. Большинство сервисов выводит вероятность фейка в процентах, поэтому принято комбинировать несколько моделей, чтобы снизить риск ложных срабатываний.

Детекторы нового поколения: трансформеры и мультимодальный анализ

Современные детекторы используют архитектуры на основе трансформеров, способные анализировать длинные видеопоследовательности и учитывать как визуальный, так и аудиоконтекст. Модели типа DeepFake-MAMBA и X-Detector-T5 используют state-space модели и механизмы перекрестного внимания для поиска несоответствий между различными модальностями.

Особенность новых детекторов в их способности работать с разнородными данными: они анализируют не только видеокадры, но и звуковую дорожку, метаданные и поведенческие характеристики в единой нейронной архитектуре. Такой подход значительно усложняет создание убедительных подделок, поскольку генератору необходимо синхронизировать все модальности.

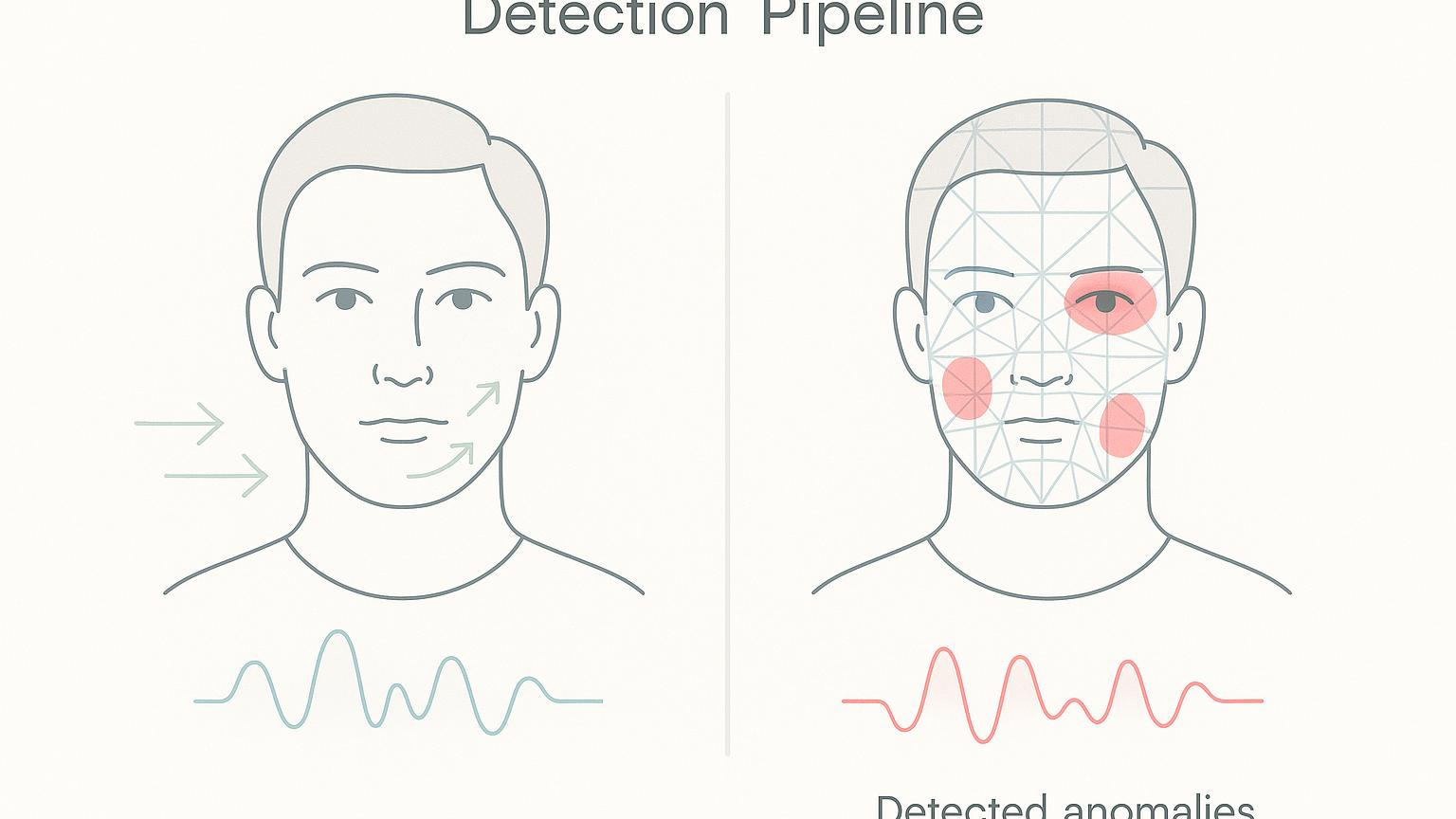

Физиологические маркеры

Исследователи Intel предложили анализировать микропульсации цвета кожи — RPPG (remote photoplethysmography). Реальное кровообращение вызывает ритмичное покраснение щёк, которое генератору сложно реконструировать. На основе этой идеи создан FakeCatcher, способный работать в реальном времени.

Другой подход — отслеживание микро-жестов: брови, микроповороты головы, непроизвольные колебания зрачков. Комплексный анализ поведения повышает точность детекции в «живых» стримах.

Биометрические отпечатки — каждый человек имеет уникальный набор мимических паттернов, манеру речи и моргания. По сути, это «поведенческая подпись», которую сложно полностью воспроизвести. Новые детекторы создают и сравнивают биометрические профили известных личностей со спорным контентом.

Инструменты и сервисы для обнаружения дипфейков

Онлайн-платформы и SaaS-сервисы

Ниже собраны популярные площадки, которые проверяют изображения, видео и даже текст на признаки генерации. Выбор зависит от бюджета, требуемой скорости и типа медиа.

Reality Defender обеспечивает проверку изображений, видео, аудио и документов в реальном времени. Платформа использует ансамбль сотен специальных моделей, доступна как веб-интерфейс и API, а результаты дополнительно снабжаются кратким объяснением («heat-map» подозрительных областей).

Sensity AI ориентируется на глубокий анализ видео. Сервис строит многоуровневые графы артефактов: от подсчёта морганий до анализа оптического потока, что повышает надёжность при потоковой проверке длинных роликов.

Deepware Scanner предлагает браузерное расширение и мобильное приложение: загрузите файл или вставьте ссылку — и получите процент вероятности дипфейка. Подходит для быстрой проверки мемов и сторис.

FaceOnLive поставляет SDK и облачный API для компаний, которым важно сверять фотографии в KYC-процессах. Поддерживается глубокий анализ EXIF и сравнение с базой известных фейков.

Intel FakeCatcher выделяется тем, что детектирует дипфейки напрямую по видеопотоку, оценивая кровоток по мелким изменениям яркости пикселей. Работает в онлайне и заявляет точность 96 % на внутренних тестах.

Microsoft Video AI Authenticator встроен в облако Azure. Алгоритм анализирует микропереходы оттенков серого и цветовую субдискретизацию, подсказывая, был ли кадр манипулирован.

WeVerify (InVID) — плагин для браузера, который автоматизирует классические OSINT-процедуры: разбор на ключевые кадры, обратный поиск изображений и проверку метаданных. Дополнительно сервис хранит известные фейки в собственном блокчейне для быстрой перекрёстной проверки.

AI or Not появился как простой тест «распознай нейросетевой арт», но теперь поддерживает видео и аудио. Есть бесплатный тариф с лимитом и платный API для интеграции в корпоративные воркфлоу.

DeepFake-o-meter — открытая платформа, объединяющая результаты восемнадцати моделей детекторов. Пользователь загружает файл, а система консенсусом выводит итоговый балл.

Resemble AI Detector специализируется на аудио; он ищет спектральные несоответствия и проверяет наличие «дыхательных пауз», заявляя до 98 % точности на корпоративных голосовых ботах.

Hume AI Multimodal Detector — новое решение, анализирующее эмоциональные и поведенческие характеристики в видео для выявления несоответствий реальному эмоциональному поведению человека.

DeepfakeDetect.AI — платформа с открытым API, специализирующаяся на анализе прямых трансляций и видеозвонков.

Среди других сервисов стоит упомянуть Attestiv, DuckDuckGoose AI, HyperVerge, Truepic Vision, Foto Forensics, Illuminarty, PlayHT Voice Classifier и десятки демо-проектов на Hugging Face Spaces. Каждая платформа балансирует между скоростью, глубиной анализа и ценой, поэтому перед подпиской полезно сравнить бесплатные тестовые лимиты.

Мобильные приложения для массового пользователя

С ростом потребления контента на мобильных устройствах появились приложения, предназначенные специально для быстрой проверки «на ходу»:

FakeShield (iOS/Android) — легковесное приложение, анализирующее загруженные фото и видео без отправки на сервер, что важно для конфиденциальности.

DeepCheck Mobile — позволяет навести камеру на экран компьютера или ТВ и мгновенно проверить транслируемый контент.

MediaVeritas — интегрируется с популярными мессенджерами для быстрой проверки входящих медиафайлов.

TruthLens — распознает и визуализирует наиболее вероятные области манипуляций в режиме дополненной реальности.

Открытые библиотеки и исследовательские фреймворки

Разработчикам, которые хотят встроить проверку в собственный продукт или провести независимое исследование, пригодятся open-source-решения.

- ONNX Deepfake Detection — коллекция готовых моделей (Xception, MesoNet, F3-Net), которые можно разворачивать на CPU и GPU без сложной настройки.

- DeepFaceLab и FaceSwap полезны и для генерации, и для детекции: исследователи создают контр-датасеты, зная точный пайплайн подделки.

- FakeCCTV — набор скриптов для проверки камер видеонаблюдения в реальном времени.

- RU-DeepFakes — библиотека и датасет для обнаружения русскоязычных дипфейков с учетом лингвистических особенностей.

- MMDF (MultiModal DeepFake) — фреймворк для мультимодального анализа медиаконтента.

- Temporal Coherence Detector — библиотека для анализа временной согласованности движений в видео.

Нишевые аудио-и биометрические детекторы

Подделки голоса и «живого присутствия» быстро набирают популярность, и рынок отвечает специализированными решениями.

- AI Voice Detector и PlayHT Voice Classifier анализируют форманты и микровибрации речи.

- Phoneme-Viseme Mismatch Detector сопоставляет артикуляцию губ с аудиодорожкой, вычисляя несоответствия.

- Oz Liveness и Facia применяют 3D-анализ лица и ультра-короткие вспышки подсветки для проверки «живого» пользователя.

- VoiceID Biometrics — создает уникальный «голосовой отпечаток» каждого человека для последующей верификации.

- DeepMind Audio Authenticator — анализирует ритмические паттерны и просодию речи для выявления синтетического происхождения.

- Emotional Coherence Analyzer — проверяет согласованность эмоциональных характеристик между голосом, мимикой и контекстом разговора.

Такие решения популярны в банковском секторе и сервисах удалённой идентификации.

Криптография и водяные знаки: защита «с рождения»

Самый надёжный способ отличать оригинал от фейка — снабдить контент криптографической подписью прямо при съёмке. Консорциум C2PA, в который входят Adobe, Microsoft и BBC, разработал универсальный формат «паспорта контента», где хранится хеш-цепочка всех изменений. Любая серьёзная манипуляция рвёт подпись, и плеер показывает предупреждение.

На аппаратном уровне камеры нового поколения впечатывают едва заметный шумовой паттерн в инфракрасном диапазоне. Любая генеративная подмена стирает этот узор, поэтому детекторы вроде Truepic Vision ловят несоответствие почти без ложных срабатываний.

Стандарты маркировки синтетического контента

В 2024-2025 годах индустрия пришла к стандартизации маркировки синтетического контента. Появились общепринятые метаданные:

CAI (Content Authenticity Initiative) — стандарт для встраивания метаданных о происхождении контента, поддерживаемый Adobe, Twitter и The New York Times.

SynthID — водяной знак от Google, встраиваемый на уровне генеративной модели, который сохраняется даже при значительных модификациях изображения.

ContentCredentials — открытый протокол для отслеживания провенанса медиаобъектов на всем жизненном цикле от создания до публикации.

Многие браузеры и платформы теперь отображают специальные индикаторы для контента с отсутствующей или нарушенной цепочкой подтверждения подлинности.

Ключевые научные работы и датасеты

Ниже приведены исследования, которые формируют методическую базу детекторов и вдохновляют разработчиков новых алгоритмов.

- Rossler D. и др. «FaceForensics++» — первый крупный датасет и бенчмарк (1000+ видео), на котором «выросли» ранние детекторы GAN-подделок.

- Pei G. и др. «Deepfake Generation and Detection: A Benchmark and Survey» — свежий обзор 2024 года, который систематизирует методы и открывает новые вызовы эпохи диффузионных моделей.

- Demir I., Ciftci U. «Real-Time Deepfake Detection with FakeCatcher» — работа Intel о пульс-детекции, доказавшая, что биосигналы сложно подделать.

- Li Y. и др. «One Shot Face Forgery Detection» — вводит концепцию Face X-ray — «рентгена» переходного слоя на границах вставленного лица.

- Zhang Z. и др. «Deepfake-Eval-2024» — in-the-wild бенчмарк новых подделок из соцсетей; показывает, что старые датасеты уже не отражают реальных угроз.

- Mittal T. и др. «RPPG-based Detection of Facial Forgery» — эмпирически подтверждает устойчивость пульс-метода на 2000+ роликах.

- Chen W. и др. «MultiModal Deepfake Detection: Beyond Visual Artifacts» (2025) — прорывное исследование, демонстрирующее, как интеграция аудио, визуальных и семантических признаков улучшает точность детекции на 17-24%.

- Karras K. и др. «Attacking Deepfake Detectors via Model Extraction» (2024) — исследование уязвимостей современных детекторов дипфейков, показывающее возможность их обхода через дистилляцию моделей.

- Serhii Y. и др. «Real-time Multi-stream Deepfake Detection on Edge Devices» (2025) — работа про эффективные алгоритмы для мобильных устройств с ограниченными вычислительными ресурсами.

Регулярное чтение свежих препринтов помогает следить за «гонкой вооружений» и обновлять сигнатуры в корпоративных детекторах.

Анализ случаев: история реальных дипфейков, которые удалось разоблачить

Для лучшего понимания методологии обнаружения дипфейков полезно изучить конкретные случаи успешного разоблачения.

Поддельное видеообращение главы корпорации (март 2024)

В 2024 году в сети появилось видео с «экстренным обращением» СЕО крупной технологической компании о проблемах в производстве, что вызвало временное падение акций на 4%. Видео было разоблачено благодаря:

- Асинхронности моргания (частота около 6 раз в минуту вместо нормальных 15-20)

- Отсутствию характерного акцента в речи, известного по интервью

- Метаданным, указывающим на постобработку в программе с известными инструментами синтеза

Компания выпустила опровержение через официальные каналы и подала иск к создателям фейка.

Поддельная пресс-конференция политика (октябрь 2024)

Накануне выборов в сети распространилось видео с признанием политика в коррупционных связях. Разоблачение произошло благодаря:

- Обнаружению несогласованности источников света (тени на лице не соответствовали освещению в помещении)

- Артефактам на границе волос, где алгоритм не смог точно воспроизвести детали

- Обратному поиску изображений, который показал, что фон был взят с реальной пресс-конференции годичной давности

Анализ был проведен журналистами в сотрудничестве с Reality Defender за 3 часа после публикации фейка.

Фальшивый звонок с угрозами (январь 2025)

Злоумышленники использовали клонированный голос для звонка с угрозами в компанию. Подделку удалось выявить благодаря:

- Анализу просодии речи (неестественные паузы между словами)

- Отсутствию фоновых шумов и эхо, характерных для телефонного разговора

- Спектральному анализу, показавшему признаки синтетического происхождения аудио

Случай демонстрирует важность быстрого реагирования и наличия протоколов проверки в экстренных ситуациях.

Образовательные инициативы и программы повышения цифровой грамотности

Параллельно с развитием технических решений формируется экосистема образовательных программ, призванных повысить осведомленность широкой аудитории о рисках дипфейков.

Академические курсы и специализации

Ведущие университеты внедряют курсы по распознаванию синтетического контента:

- MIT Media Lab — программа «Критическое потребление медиа в эпоху генеративного ИИ»

- Стэнфордский университет — курс «Цифровая криминалистика и обнаружение дипфейков»

- МФТИ — специализация «Методы анализа подлинности медиаконтента» на факультете Искусственного интеллекта

Инициативы для журналистов и специалистов медиа

Профессиональные программы повышения квалификации:

- Reuters Institute — тренинги по верификации контента для журналистов-расследователей

- Bellingcat — открытые мастер-классы по OSINT-методам обнаружения фейков

- Проект «Медиаграмотность» — русскоязычные вебинары для региональных СМИ

Инициативы для широкой публики

Проекты, направленные на массовое повышение осведомленности:

- DetectFake Challenge — интерактивная платформа, где пользователи тренируются отличать реальные и поддельные медиафайлы

- Digital Literacy Coalition — серия видеоуроков и интерактивных тестов для школьников и их родителей

- AI Safety Community — локальные мероприятия и воркшопы по цифровой безопасности в городах России

Процедуры проверки: пошаговый сценарий на каждый день

Независимо от того, используете ли вы тяжёлый SaaS или лишь смартфон, полезно придерживаться алгоритма:

- Первичный осмотр. Замедлите ролик, включите звук, ищите визуальные «скачки» и аудио-глитчи.

- Скрин и ELA. Сделайте стоп-кадр, прогоните его через Foto Forensics и отметьте зоны аномалий.

- Детектор. Загрузите файл в Reality Defender или Deepware Scanner и зафиксируйте процент.

- Контекст. Проверьте, публиковали ли новость другие источники, и сравните временные метки.

- Обратный поиск. Используйте InVID → Keyframe Extraction → Google Images для каждого ключевого кадра.

- Запрос оригинала. Попросите у автора исходник высокого качества; нежелание делиться — тревожный сигнал.

- Мультимодальный анализ. Проверьте согласованность между видео, аудио и контекстом сообщения.

- Консультация с экспертами. При высоких ставках обратитесь к профессиональным фактчекерам.

Комбинация хотя бы двух методов статистически снижает риск ошибочного доверия фейку.

Протоколы проверки для организаций

Для компаний, которые регулярно сталкиваются с необходимостью проверки контента, рекомендуется внедрить формализованный протокол:

- Создание тревожной цепочки — определите, кто отвечает за первичную проверку, эскалацию и принятие решений

- Автоматизированный скрининг — настройте интеграцию с API детекторов для массовой проверки входящего контента

- Двойная верификация — важные материалы должны проверяться двумя независимыми специалистами

- Документирование процесса — ведите журнал подозрительных случаев и методов их разрешения

- Регулярные тренинги — обновляйте знания команды о новых типах подделок и методах их выявления

Законодательство и саморегуляция

Европейский AI Act (утверждён весной 2025) обязывает платформы маркировать синтетический контент и внедрять базовые детекторы. Нарушение грозит штрафом до 6 % глобального оборота. В США обсуждается DEEPFAKES Accountability Act, вводящий уголовную ответственность за подделки, влияющие на выборы.

Социальные сети уже внедряют превентивные меры. Meta автоматически ставит тег «AI Generated» при высоком балле вероятности, а TikTok требует от автора нажать кнопку «Synthetic Media». Бизнес-модели сервисов вроде Reality Defender демонстрируют, что борьба с фейками может быть и коммерчески успешной.

Региональные законодательные подходы

Помимо упомянутых европейских и американских инициатив, стоит отметить региональные подходы:

Китай ввел самое жесткое в мире регулирование через «Положение о генеративном ИИ» (2023), требующее обязательную регистрацию всех генеративных моделей и явную маркировку любого синтетического контента.

Индия разрабатывает «Закон о цифровом гражданстве», предусматривающий создание национального реестра верифицированного контента и серьезные санкции за распространение дипфейков общественных деятелей.

Россия внесла поправки в закон «Об информации», обязывающие указывать факт использования ИИ при создании контента и предусматривающие штрафы за дезинформацию с использованием дипфейков.

Австралия приняла «Кодекс предотвращения вреда от синтетического контента», который фокусируется на создании отраслевых стандартов саморегулирования.

Интеграция с фактчекинговыми экосистемами

Обнаружение дипфейков становится частью более широких инициатив по проверке фактов и борьбе с дезинформацией:

Коллаборации с фактчекинговыми организациями

Ведущие детекторы дипфейков интегрируются с международными платформами проверки фактов:

- International Fact-Checking Network (IFCN) совместно с Reality Defender создали интегрированную панель для быстрой передачи подозрительного контента профессиональным фактчекерам

- Full Fact (Великобритания) разработал автоматизированную систему, которая сопоставляет результаты детектора дипфейков с собственной базой знаний для контекстуальной проверки

- Сервис «Проверено» в России предлагает общественный дашборд распространенных дипфейков с разбором методов их создания и разоблачения

Индустриальные консорциумы и партнерства

Крупные технологические компании объединяют усилия для создания общих стандартов:

- Синтетическая медиа-коалиция — альянс Google, Microsoft, Adobe и Meta, разрабатывающий общие стандарты маркировки контента

- Deepfake Detection Challenge 2.0 — новая инициатива с призовым фондом $20 млн для стимулирования создания более точных детекторов

- AI Trust Index — отраслевая инициатива по созданию репутационного рейтинга источников контента

Будущее: перманентная гонка генераторов и детекторов

Оптимисты считают, что чем сложнее генератор, тем заметнее его след. Пессимисты уверены, что качество подделок будет опережать детекторы. Скорее всего, мы придём к «вооружённому перемирию»: обязательные водяные знаки, zero-trust-платформы с отказом показывать «беспризорный» контент и развитое медиа-сообщество, которое умеет быстро верифицировать информацию.

Лучшая стратегия для профессионала — гибрид: автоматический скрининг, ручная экспертиза, публичная прозрачность расследований. Лучшая стратегия для всех остальных — здоровый скепсис и привычка перепроверять сенсацию хотя бы дважды.

Адаптивные системы защиты и многоуровневая верификация

Будущее детекции дипфейков, вероятно, будет строиться вокруг многоуровневых верификационных систем:

- Интеллектуальные деплоймент-платформы — системы, автоматически обучающиеся на новых типах подделок через федеративное обучение

- Системы дуального анализа — параллельное применение физически обоснованных детекторов (исследующих нарушения законов оптики, акустики) и статистических моделей

- Инфраструктура цифрового доверия — повсеместное внедрение провенанс-цепочек на основе блокчейна для всего публикуемого контента

- Национальные центры реагирования на дипфейки — по аналогии с центрами реагирования на кибер-угрозы (CERT)

Заключение: критическое мышление как новая гигиена

Дипфейки — это лакмусовая бумажка зрелости общества. Машина научилась лгать убедительно, а значит человек должен научиться задавать правильные вопросы. Инструменты уже существуют, сообщество растёт, а значит шансов у правды всё ещё больше, чем у обмана.

В мире, где визуальные доказательства перестают быть абсолютной истиной, особую ценность приобретают навыки критического мышления, цифровой грамотности и медийной гигиены. Важно помнить, что технологии сами по себе нейтральны — их влияние определяется намерениями и ответственностью людей, которые их используют.

Борьба с дипфейками — это не только технологическая задача, но и социальный вызов, требующий комплексного подхода: от совершенствования алгоритмов до формирования новой культуры потребления информации. И хотя идеальных решений пока нет, объединенные усилия исследователей, индустрии, законодателей и общества создают надежную основу для мира, где правда все еще имеет значение.